Por León Hernández

Numerosas elecciones están por realizarse este 2024 a escala global. A los comicios en El Salvador, en el cual resultó reelegido Nayib Bukele, le seguirán otros cinco en América Latina, los de Panamá, República Dominicana, México, Uruguay y Venezuela, en ese orden. El advenimiento de estos comicios ha puesto en relieve la necesidad de prevenir campañas de desinformación y el potencial uso de Inteligencia Artificial para manipular al ciudadano ha puesto de relieve más la forma, que el fondo del asunto.

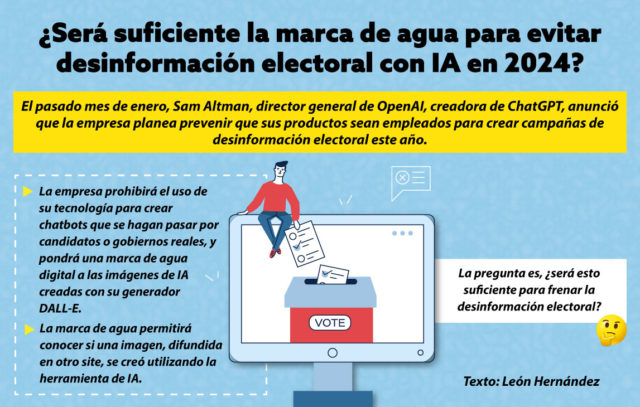

El pasado mes de enero, Sam Altman, director general de OpenAI, creadora de ChatGPT, anunció que la empresa planea prevenir que sus productos sean empleados para crear campañas de desinformación electoral este año. En concreto, la empresa prohibirá el uso de su tecnología para crear chatbots que se hagan pasar por candidatos o gobiernos reales, y pondrá una marca de agua digital a las imágenes de IA creadas con su generador DALL-E. La marca de agua permitirá conocer si una imagen, difundida en otro site, se creó utilizando la herramienta de IA.

OpenAI, es sólo una entre las muchas que desarrollan herramientas avanzadas de Inteligencia Artificial. Ciertamente, el ejemplo que está poniendo esta startup de inteligencia artificial, con sede en San Francisco, Estados Unidos, es loable, pues permea un ensayo de políticas y medidas para evitar incidir, a través de manipulación con Deep fake, en los procesos comiciales. Altman añadió que no permitirá a sus usuarios crear aplicaciones para campañas políticas, hasta que no se conozca a fondo cuál es el poder persuasivo de su tecnología.

Expertos y asesores en democracia, como Mekela Panditharatne, del programa de democracia del Centro Brennan para la Justicia, han calificado como positivos los anuncios de OpenAI contra la desinformación electoral, pero sin encontrar la respuesta sobre lo que ocurrirá si otras herramientas distintas a ChatGPT y DALL-E, de OpenAI, siguen su camino sin incorporar acciones de protección contra la desinformación electoral.

La falta de autorregulación por parte de la totalidad de las empresas, implicaría mecanismos de regulación que no han sido aún contemplados en materia de Inteligencia Artificial. La pregunta es, ¿será esto suficiente para frenar la desinformación electoral?

La inteligencia artificial es solo una de las tantas herramientas en materia de desinformación. Desde mentiras en el discurso público, pasando por creación de contenidos distorsionadores de la realidad, tales como usurpaciones de medios, audios de dudosa procedencia, descontextualizaciones de hechos con material audiovisual relativo a otras latitudes o correspondientes a instancias temporales pasadas, se ponen en la mesa de laboratorios de desinformación. La Inteligencia Artificial es solo una de las vertientes. Corresponde a ciudadanos, periodistas, e iniciativas como el Observatorio Venezolano de Fake News, Cotejo.info, entre otras, seguir explorando en herramientas y métodos de verificación, pues el fenómeno de la desinformación en época electoral es una constante en la historia de los procesos de decisión política.

¡Mantente informado! Únete a nuestro canal de WhatsApp o Telegram a través de los siguientes links:

WhatsApp: https://chat.whatsapp.com/FxbVGD5gQwi0xAKKWW4fEd

Telegram: https://t.me/diariodelosandes